-

Compteur de contenus

29 301 -

Inscription

-

Dernière visite

-

Jours gagnés

1 038

Type de contenu

Profils

Forums

Calendrier

Tout ce qui a été posté par Ldfa

-

Changements principaux : * Amélioration de la traduction des champs de langue localisés. - Correction de l'indisponibilité de la création et de l'édition de nouveaux dossiers dans la barre latérale de Maxnote. - Correction d'un problème où les extensions ne pouvaient pas être supprimées et réapparaissaient après le redémarrage. - Correction de plantages connus.

-

Maxthon 7.3.1.7200 Bêta pour Windows est sorti aujourd'hui, il apporte son lot de nouvelles fonctionnalités / améliorations et de corrections de bugs. Téléchargement : https://github.com/maxthon/Maxthon/releases Les changements en français sont là. Vous pouvez également vous abonner au groupe Telegram NBdomain & MX6 pour faire remonter vos demandes d'améliorations et bugs rencontrés. Source : https://forum.maxthon.com/d/1018-maxthon-pc-7317200-beta

-

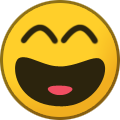

Changements principaux : + Ajout d'Uumail au menu principal : Cachez votre adresse email réelle, générez des emails virtuels par lots - votre email VPN. + Ajout d'un paramètre pour basculer l'affichage de la barre d'outils rapide dans l'éditeur de notes. + Ajout d'un paramètre de recherche intelligente uuGPT : Désactiver l'option 'Afficher dans uuGPT' dans la barre d'adresse via Paramètres > Confidentialité et sécurité > Barre d'adresse intelligente. * Synchronisation Maxnote optimisée. - Correction de l'ordre incorrect d'ouverture des onglets dans le navigateur - Correction des plantages de page causés par la logique d'impression - Correction de l'affichage trop large dans la nouvelle interface de téléchargement - Correction de l'affichage incorrect de la langue dans certaines parties de l'interface - Correction d'un problème où la fenêtre d'image dans l'image ne pouvait pas être fermée ou renvoyée à l'onglet sur certaines pages web. - Correction d'un problème où des onglets fixes étaient ouverts pendant l'initialisation en mode incognito.

-

Maxthon 7.3.1.7000 pour macOS est sorti aujourd'hui, avec son lot d'améliorations et de corrections de bugs. Téléchargement : https://download.mxfast.com/mac/Maxthon_7.3.1.7100.dmg Les changements en français sont ici. Source : https://forum.maxthon.com/d/1017-maxthon-mac-7317000

-

Changements principaux : + Ajout d'Uumail au menu principal : Cachez votre adresse email réelle, générez des emails virtuels par lots - votre email VPN. + Ajout d'un paramètre pour basculer l'affichage de la barre d'outils rapide dans l'éditeur de notes. + Ajout d'un paramètre de recherche intelligente uuGPT : Désactiver l'option 'Afficher dans uuGPT' dans la barre d'adresse via Paramètres > Confidentialité et sécurité > Barre d'adresse intelligente. * Optimisation de la synchronisation Maxnote. - Correction de l'affichage trop large dans la nouvelle interface de téléchargement. - Correction de l'affichage incorrect de la langue dans certaines parties de l'interface. - Correction d'un problème où des onglets fixes étaient ouverts lors de l'initialisation en mode incognito. - Correction de plantages connus.

-

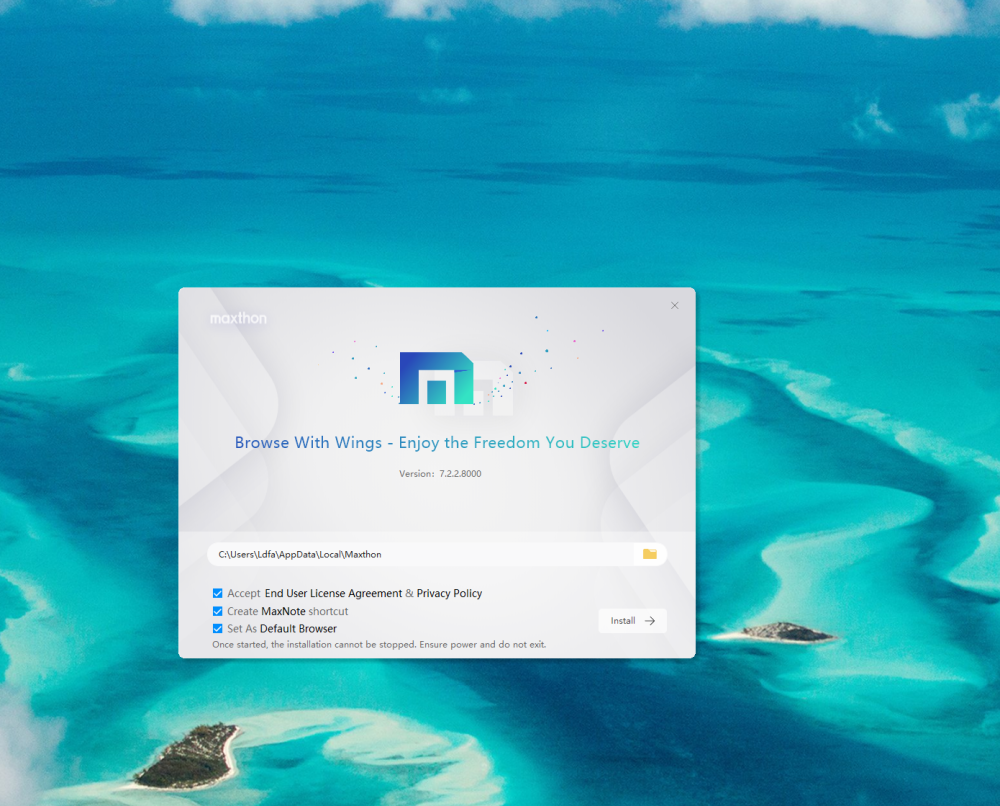

Maxthon 7.2.2.8000 stable pour Windows 7 est sorti aujourd'hui, il apporte son lot de nouvelles fonctionnalités / améliorations et de corrections de bugs. Téléchargement : https://github.com/maxthon/Maxthon/releases/tag/7.2.2.8000 Attention : Cette version est compatible avec Windows 7, mais elle utilise une ancienne version 109 de Chromium. Les changements en français sont là. Vous pouvez également vous abonner au groupe Telegram NBdomain & MX6 pour faire remonter vos demandes d'améliorations et bugs rencontrés. Source : https://forum.maxthon.com/d/1016-maxthon-pc-7228000-win7

-

Avant de changer de forfait mobile, il faut aller sur ce site - Numerama

Ldfa a posté un sujet dans Mon Wallabag

durée de lecture : 3 min Quelle qualité avez-vous vraiment avec votre forfait mobile quand vous êtes chez vous, à votre travail, en déplacement ou sur votre lieu de vacances ? Depuis plusieurs années, le régulateur des télécoms a une carte décisive pour connaître la situation près de chez soi : Mon Réseau Mobile. Cette carte pour connaître la couverture et la qualité de service vient d’être actualisée. Il existe pléthore de très bons forfaits mobiles 4G et 5G en 2025. Sauf que tous les opérateurs de téléphonie n’ont pas toujours les mêmes performances partout sur l’ensemble du territoire français. En fonction de la répartition des antennes relais et des circonstances sur le terrain, certains réseaux s’en sortent mieux que d’autres. Pour déterminer quel opérateur a le meilleur réseau mobile, le régulateur des télécoms publie chaque année un bilan général sur le pays entier, qui est également décliné par thème : dans les grandes villes, à la campagne, sur les routes, sur les sites touristiques ou selon des critères techniques spécifiques, tels que le débit, la couverture, etc. Mais ce point d’étape n’offre qu’une photographie annuelle, qui ne permet pas de mettre en relief les particularités locales. C’est justement là qu’une autre carte de suivi de l’Autorité de régulation des communications électroniques (Arcep) entre en jeu : Mon Réseau Mobile, qui permet de voir la situation à un niveau beaucoup plus local. Une carte qui détaille la couverture, les zones à couvrir, la qualité du réseau… Cette carte existe certes depuis des années. On en parlait déjà en 2020, par exemple. Mais le 8 juillet 2025, l’Arcep a annoncé une révision notable de son outil cartographique, avec notamment une « interface repensée » afin de « refléter plus finement l’expérience internet mobile » du public, et des informations « enrichies ». En particulier, ces nouvelles cartes « vont permettre d’offrir une plus grande précision en distinguant quatre niveaux (de ‘absence de couverture’ à ‘très bonne couverture’), afin de mieux refléter la réalité vécue par les utilisateurs », précise le régulateur des télécoms. Un dégradé de plusieurs couleurs est visible pour refléter ce niveau de couverture. Un exemple de zoom sur l’Essonne. // Source : Capture d’écran Avec la carte, on peut ainsi faire ressortir : la couverture théorique ; les tests de qualité réseau ; les antennes et déploiements ; les zones à couvrir ; les signalements de problèmes (J’alerte l’Arcep). L’Arcep signale au passage que cette mise à jour a aussi pris en compte des besoins plus experts. Cela inclut des statistiques territoriales adaptées à la zone sélectionnée, un fond de plan satellitaire pour mieux se repérer sur les cartes, ainsi que l’indication des antennes indisponibles (en panne ou en travaux), mises à jour quotidiennement Quel réseau dans les trains ? Sur la route ? Dans la France d’outre-mer ? Il existe par ailleurs des options de tri et de recherche pour faire ressortir une région, un département ou une commune, mais aussi certains axes. On pense aux trains (TGV, Intercités, TER, RER, Transiliens, métros), mais aussi aux principales routes. Chaque section dispose ensuite de sous-options pour affiner les informations. Point notable et appréciable : le travail de suivi de l’Arcep ne se limite pas à la seule métropole. Les territoires de la France d’outre-mer sont là, avec des visualisations de la Guyane, la Guadeloupe, la Martinique, la Réunion, Mayotte, Saint-Barthélemy et Saint-Martin. Deux absents notables à noter : la Polynésie française et la Nouvelle-Calédonie. Pour finir, « Mon réseau mobile permet également de consulter l’emplacement des zones qui devront être couvertes dans les 24 mois par les opérateurs au titre du dispositif de couverture ciblée », pointe l’Arcep. Lancé en 2018, ce plan vise à améliorer localement la couverture des territoires, en lien avec les besoins des collectivités territoriales. Pour aller plus loin Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp ! Afficher l’article complet -

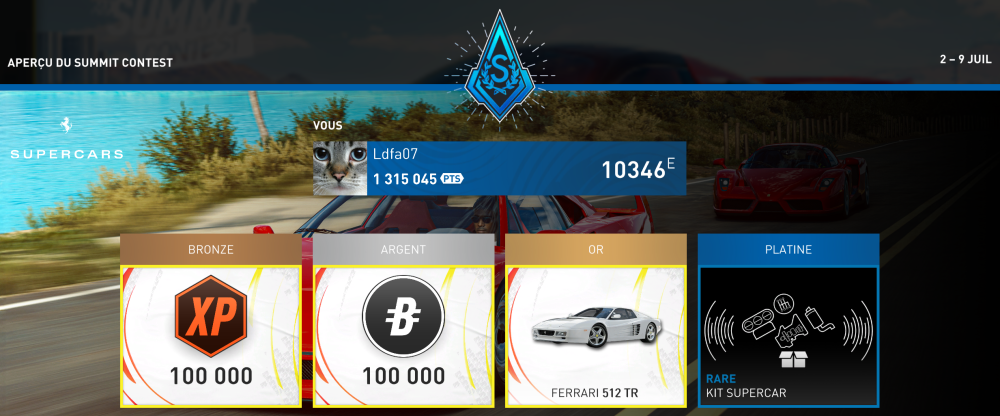

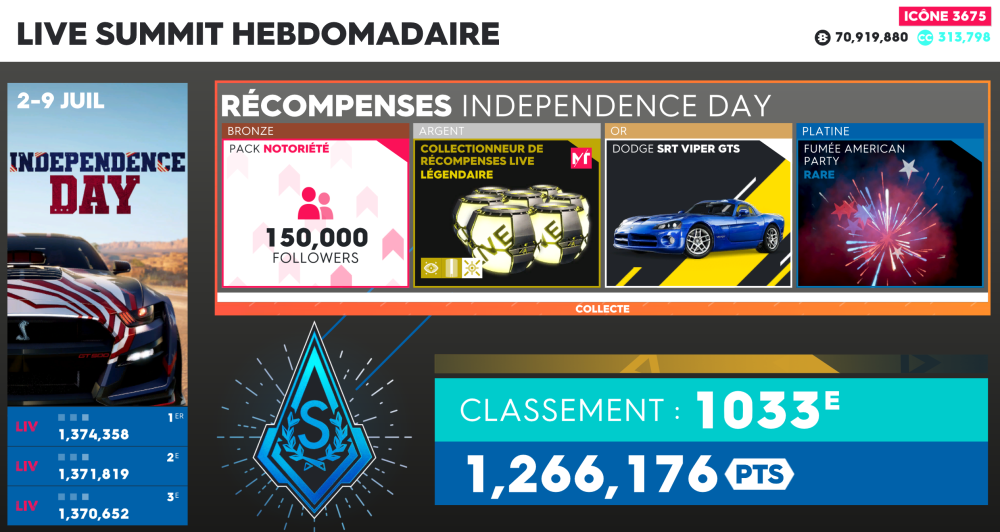

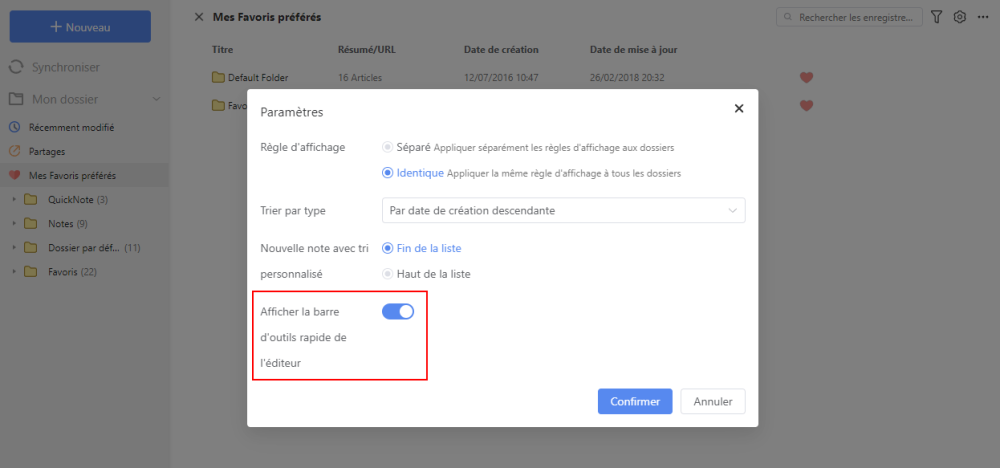

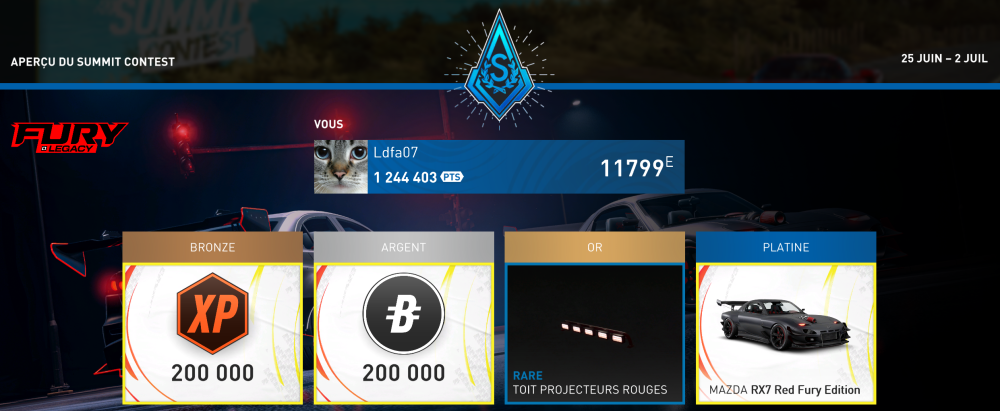

Je termine encore Platine cette semaine, mais avec la limite des 15000 places pour le Platine, c'est beaucoup plus facile...

-

-

Comme d'habitude, c'est le plus gros problème des Devs de Maxthon...

-

Je viens de voir la réponse sur le FI : https://forum.maxthon.com/d/233-maxthon-pc-7317000-beta/7

-

Win Traduction française de Mx7 pour Windows

Ldfa a répondu à un(e) sujet de Ldfa dans Traductions françaises de Maxthon sur Crowdin

Traduction approuvée. fr.ini -

Facebook Suppression du compte Maxthon France sur Facebook

Ldfa a posté un sujet dans Nouveautés du Site Maxthon-fr.com

Je viens de demander la suppression de mon compte Facebook et du compte Maxthon France associé. En effet, je ne pouvais plus accéder à mon compte Facebook à partir de mon PC, seulement l'accès via Smartphone fonctionnait encore. Malgré mes demandes auprès de Facebook (le système étant tellement obscur et compliqué, j'ai des gros doutes sur son efficacité) et sans réponse ni solution à ce jour, les comptes seront définitivement supprimés le 6 août 2025. Le compte Facebook de Maxthon France n'était plus MAJ depuis plus d'un an, ce n'est donc pas une perte... -

Win Traduction française de Mx7 pour Windows

Ldfa a répondu à un(e) sujet de Ldfa dans Traductions françaises de Maxthon sur Crowdin

There are new strings to translate in the Maxthon pour Windows project. You were a project participant previously so your help will be appreciated a lot. 1 new string for translation (4 words). -

Changements principaux : + Ajout d'un paramètre permettant de basculer l'affichage de la barre d'outils rapide dans l'éditeur de notes. - Correction d'un problème où la fenêtre Image dans l'image ne pouvait pas être fermée ou retournée à l'onglet sur certaines pages web. - Correction d'un problème où des onglets fixes étaient ouverts pendant l'initialisation en mode incognito. - Correction d'un problème où les extensions désactivées étaient réactivées après le redémarrage du navigateur.

-

Maxthon 7.3.1.7000 Bêta pour Windows est sorti aujourd'hui, il apporte son lot de nouvelles fonctionnalités / améliorations et de corrections de bugs. Téléchargement : https://github.com/maxthon/Maxthon/releases Les changements en français sont là. Vous pouvez également vous abonner au groupe Telegram NBdomain & MX6 pour faire remonter vos demandes d'améliorations et bugs rencontrés. Source : https://forum.maxthon.com/d/233-maxthon-pc-7317000-beta

-

Je termine Platine encore cette semaine, mais j'ai eu de la chance, car la limite est passée de 10000 à 15000 places.

-

-

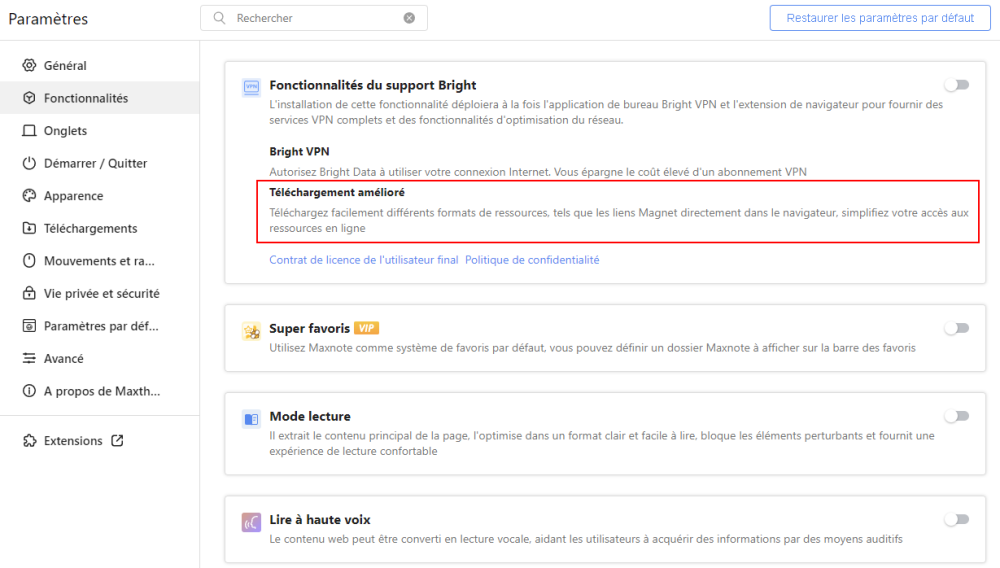

Vous devez activer le "Téléchargement amélioré" pour télécharger le lien Magnet.

Ldfa a répondu à un(e) sujet de franz dans Questions et astuces sur Mx6 & Mx7

C'est ici dans les Paramètres : Personnellement, je te le déconseille, sauf si tu sais ce que tu fais... -

Changements principaux : - Correction des blocages de pages causés par la logique d'impression. - Correction d'un problème de temps pour le téléchargement de vidéos. - Correction de l'affichage trop large dans la nouvelle interface de téléchargement. - Correction de l'affichage incorrect de la langue dans certaines parties de l'interface.

-

Maxthon 7.3.1.6800 Bêta pour Windows est sorti aujourd'hui, il apporte son lot de nouvelles fonctionnalités / améliorations et de corrections de bugs. Téléchargement : https://github.com/maxthon/Maxthon/releases Les changements en français sont là. Vous pouvez également vous abonner au groupe Telegram NBdomain & MX6 pour faire remonter vos demandes d'améliorations et bugs rencontrés. Source : https://forum.maxthon.com/d/165-maxthon-pc-7316800-beta

-

Win Traduction française de Mx7 pour Windows

Ldfa a répondu à un(e) sujet de Ldfa dans Traductions françaises de Maxthon sur Crowdin

, j'ai approuvé la traduction. fr.ini -

Win Traduction française de Mx7 pour Windows

Ldfa a répondu à un(e) sujet de Ldfa dans Traductions françaises de Maxthon sur Crowdin

There are new strings to translate in the Maxthon pour Windows project. You were a project participant previously so your help will be appreciated a lot. 2 new strings for translation (7 words). -

Des infos sur Pop_OS...