Rechercher dans la communauté

Affichage des résultats pour les étiquettes 'Proxmox'.

9 résultats trouvés

-

Linux BentoPDF : la boite à outils PDF dans votre navigateur Web - IT Connect

Ldfa a posté un sujet dans Mon Wallabag

IT-Connect Publié le 26 janvier 2026 Par Florian BURNEL it-connect.fr Environ 5 minutes de lecture BentoPDF se présente comme une alternative à Stirling, PDFgear voire même à Adobe Acrobat dans une moindre mesure. Cette boite à outils PDF accessible directement dans votre navigateur Web regroupe des dizaines d'outils pour manipuler vos documents. Au-delà d'être open source, elle se veut respectueuse de la vie privée. Cet article explique comment installer votre instance de BentoPDF à l'aide de Docker. BentoPDF n'est pas la seule boite à outils PDF accessible directement depuis un navigateur et auto-hébergeable : Stirling-PDF reste une référence dans ce domaine, avec en complément des applications pour les ordinateurs. Pour autant, BentoPDF suscite de l'intérêt, la preuve : son nombre d'étoiles sur GitHub est passé de 0 à plus de 10 000 en à peine 3 mois. Voici les avantages de la solution BentoPDF : Application 100% client-side : un gros plus pour la confidentialité, car le traitement s'effectue dans le navigateur de l'utilisateur. Cela signifie que votre fichier n'est pas chargé sur le serveur où est installé BentoPDF. Libre d'accès : l'application est accessible sans authentification, ni compte. Tous les outils du toolkit sont gratuits, sans limitation, que ce soit pour traiter 1 ou X documents. Mode hors ligne pour l'accès aux outils. Conformité RGPD, CCPA et HIPAA. Ce projet open source est distribué sous licence AGPL-3.0. Des licences commerciales abordables sont proposées à ceux qui veulent intégrer BentoPDF au sein d'outils propriétaires (ou en source fermée). Je vous recommande de consulter cette page pour bien comprendre les subtilités selon les cas d'usage. Pour utiliser les outils de BentoPDF, vous avez plusieurs options : l'utiliser directement en ligne depuis le site web de la solution ou l'auto-héberger sur un ordinateur, un serveur ou encore un NAS. Aujourd'hui, je vous propose d'installer BentoPDF à l'aide de Docker Compose. Site officiel - BentoPDF GitHub - bentopdf Les outils de BentoPDF Les nombreux outils de BentoPDF sont organisés au sein de plusieurs catégories. On retrouve notamment : Éditer et annoter Dans la catégorie "Edit & Annotate", BentoPDF met à votre disposition des outils pour retravailler vos documents en profondeur. L'outil central est le PDF Editor, qui transforme votre fichier en espace de travail : vous pouvez y annoter du texte, surligner des passages, ou encore insérer des images et des formes. Il est accompagné par d'autres outils pour générer une table des matières, compléter un formulaire, signer un PDF, supprimer les pages blanches ou encore ajouter un filigrane. Ci-dessous un aperçu de l'outil PDF Editor : Convertir au format PDF Que ce soit un document, une image ou encore certains formats exotiques, BentoPDF est capable de convertir de nombreux formats de fichiers au format PDF. Ci-dessous, un extrait partiel des outils de cette catégorie. Convertir un PDF dans un autre format L'opération inverse est également possible, à savoir convertir un PDF dans un autre format. Cette section contient aussi un outil plutôt cool pour extraire toutes les images d'un document PDF. Organiser et gérer Cette section contient des outils pour diviser, fusionner ou encore supprimer des pages dans un document PDF. Vous pouvez aussi réorganiser les pages, embarquer un fichier dans un document PDF ou simplement effectuer des rotations de page. Optimiser et réparer Cette section contient des outils pour compresser et optimiser un PDF, réparer un document corrompu ou encore supprimer les protections comme un mot de passe. Sécuriser un PDF Enfin, la dernière section concerne la sécurité des documents PDF. Elle contient des outils pour chiffrer et déchiffrer un document PDF (en AES-256 bits), supprimer toutes les métadonnées (voire même tous les éléments comme les annotations, etc.) ou encore verrouiller un document. Ci-dessous, un aperçu de l'outil "Encrypt PDF" permettant de chiffrer un document PDF via l'ajout d'un mot de passe. Toutes ces fonctionnalités sont accessibles directement dans votre navigateur Web, avec un traitement effectué en local. Installation de BentoPDF avec Docker Compose Désormais, passons à l'installation de BentoPDF avec Docker (via Docker Compose). Vous devez donc disposer de Docker sur votre machine, que ce soit sous Windows, Linux ou macOS (ou votre NAS). Tutoriel - Installation de Docker sur Linux Le fichier docker-compose.yml ci-dessous est créé dans le répertoire /opt/docker-compose/bentopdf. Il est à noter que cette application ne stocke aucune donnée, il n'est donc pas nécessaire de déclarer un volume. Cet exemple est basé sur celui mis à disposition sur le site GitHub de BentoPDF. Attention, deux images Docker distinctes sont distribuées : bentopdf qui reprend l'apparence complète du site web officiel et bentopdf-simple qui reprend uniquement la partie boite à outils (cette version me semble plus pertinente pour un déploiement en local). services: bentopdf: image: bentopdf/bentopdf-simple:latest container_name: bentopdf restart: unless-stopped ports: - '8080:8080' environment: - DISABLE_IPV6=true Quelques informations supplémentaires : L'application BentoPDF sera accessible sur le port 8080 ; si vous souhaitez utiliser un autre port, changez la valeur de gauche. La variable d'environnement DISABLE_IPV6=true sert à désactiver IPv6 pour utiliser uniquement IPv4. Elle est facultative (tout dépend de votre environnement). Enregistrez et fermez le fichier. À titre d'information, voici une configuration basique pour publier BentoPDF avec le reverse proxy Traefik : services: bentopdf: image: bentopdf/bentopdf-simple:latest container_name: bentopdf restart: unless-stopped environment: - DISABLE_IPV6=true networks: - frontend labels: - "traefik.enable=true" - "traefik.docker.network=frontend" - "traefik.http.routers.bentopdf-https.rule=Host(`bentopdf.it-connectlab.fr`)" - "traefik.http.routers.bentopdf-https.entrypoints=websecure" - "traefik.http.routers.bentopdf-https.tls=true" - "traefik.http.routers.bentopdf-https.tls.certresolver=ovhcloud" - "traefik.http.services.bentopdf-https.loadbalancer.server.port=8080" - "traefik.http.routers.bentopdf-https.middlewares=crowdsec@file,tinyauth" - "tinyauth.apps.bentopdf.config.domain=bentopdf.it-connectlab.fr" networks: frontend: external: true Cette configuration protège l'application avec Tinyauth (page d'authentification) et CrowdSec (détection des attaques) en tant que middlewares Traefik. Lancez la construction du projet : docker compose up -d Votre boite à outils PDF vous attend ! Elle est accessible sur l'adresse IP de votre hôte Docker sur le port 8080, ou sur un autre port selon la configuration définie. Ensuite, vous n'avez plus qu'à commencer à jouer avec les outils. Conclusion BentoPDF est une boite à outils PDF très complète et prometteuse. Directement accessible dans votre navigateur, elle met à votre disposition un ensemble d'outils pratiques : la manipulation de documents PDF est le quotidien de nombreux utilisateurs. Vous pouvez tout à fait héberger cette application sur votre serveur et la mettre à disposition de plusieurs utilisateurs, le tout en préservant la confidentialité grâce à un traitement effectué du côté client. C'est le gros plus de cette solution et cela vous évite de déployer des applications en local sur chaque machine. Qu'en pensez-vous ? Ingénieur système et réseau, cofondateur d'IT-Connect et Microsoft MVP "Cloud and Datacenter Management". Je souhaite partager mon expérience et mes découvertes au travers de mes articles. Généraliste avec une attirance particulière pour les solutions Microsoft et le scripting. Bonne lecture. Afficher l’article complet -

Cachem Publié le 26 janvier 2026 Par Fx cachem.fr Environ 5 minutes de lecture Nous sommes en 2026 et les choses ont pas mal évolué ces derniers mois. À une certaine époque, les systèmes DIY pour NAS se comptaient sur les doigts d’une main : ce n’est plus le cas. Aujourd’hui, on trouve des solutions très abouties, avec un niveau de qualité proche du monde professionnel, comme TrueNAS Scale ou Unraid, des options intermédiaires comme OpenMediaVault (OMV), et d’autres plus accessibles et plus souples, comme CasaOS, ZimaOS ou UmbrelOS. Nous aborderons également le cas de Proxmox… Qu’est-ce que le DIY pour les NAS ? Le concept de NAS DIY (Do It Yourself) repose sur une idée simple : s’affranchir du verrouillage matériel des constructeurs (Synology, QNAP, Asustor…). Au lieu d’acheter un boîtier propriétaire, vous sélectionnez vos propres composants (boîtier, processeur, RAM, contrôleurs…) ou vous recyclez un ancien PC. Cette approche offre 2 avantages majeurs : Rapport performance/prix : pour le prix d’un NAS 4 baies du commerce équipé d’un processeur souvent limité, vous pouvez assembler une machine capable de gérer du transcodage 4K, des dizaines de conteneurs Docker, des machines virtuelles… Évolutivité : vous n’êtes plus limité par le nombre de ports, la mémoire soudée ou les choix matériels du constructeur. Votre NAS évolue avec vos besoins. À cela s’ajoute un point souvent sous-estimé : la possibilité de donner une seconde vie à un NAS qui ne reçoit plus de mises à jour… Qu’est-ce qu’un système DIY pour les NAS ? On me pose souvent la question : pourquoi parler de « système » et pas simplement de « système d’exploitation (OS) » pour NAS ? Parce qu’en 2026, un NAS moderne n’est plus seulement un serveur de partage de fichiers (SMB/NFS). C’est une plateforme qui combine trois couches complémentaires : OS : généralement Linux, il gère le matériel et le système de fichiers (ZFS, Btrfs, XFS…) ; Interface web : outil d’administration au quotidien, qui permet de gérer stockage, utilisateurs, services, mises à jour et supervision (sans passer par des lignes de commande) ; Applications : écosystème de services que vous hébergez qui était la force des fabricants historiques… mais maintenant Docker est devenu central. Les poids lourds : Performance et stockage massif Ces solutions visent d’abord la fiabilité et une gestion sérieuse du stockage. TrueNAS Scale : l’incontournable Avec ses évolutions récentes, TrueNAS Scale s’est imposé comme une référence du NAS DIY. Son point fort, c’est la protection des données grâce à ZFS (snapshots, auto-réparation, intégrité), avec une approche très “pro”. En contrepartie, ZFS reste relativement rigide : étendre un pool en ajoutant “juste un disque” n’est pas aussi souple que sur d’autres solutions. Pour exploiter ZFS dans de bonnes conditions, il est recommandé d’avoir beaucoup de mémoire vive/RAM (ECC de préférence). Si votre priorité est la pérennité et la sécurité des données, TrueNAS Scale est un excellent choix. Unraid : la flexibilité avant tout Toujours très populaire chez les particuliers, Unraid brille par sa capacité à gérer des disques hétérogènes (marques et tailles différentes) avec une grande simplicité. Son système de parité permet d’ajouter un disque facilement, au fil de l’eau. Son interface est aussi l’une des plus accessibles et sa gestion de la virtualisation (VM avec passthrough GPU) est une référence pour les configurations hybrides. Le point à intégrer dans l’équation : son modèle économique a évolué. Les mises à jour sont désormais liées à un abonnement, sauf licence à vie plus onéreuse. Cela le place face à une concurrence gratuite de plus en plus solide. Unraid reste un excellent choix pour le multimédia, l’hébergement d’applications et le recyclage de disques, à condition d’accepter le coût de la licence. L’intermédiaire OpenMediaVault est construit autour d’une base Debian, avec une philosophie simple : rester léger, stable et relativement proche de Linux. OMV tourne sur à peu près tout, y compris sur du matériel ancien. Il laisse plus de latitude pour personnaliser l’OS sous-jacent que certaines solutions plus “encadrées”. En revanche, l’interface est plus austère et demande souvent un peu plus de connaissances pour obtenir une configuration parfaitement propre (permissions, services, supervision, sauvegardes). C’est une solution cohérente pour les utilisateurs à l’aise avec Linux qui veulent un NAS sans fioritures, sur du matériel modeste. La nouvelle vague : simplicité et one-click Ici, l’objectif est clair : privilégier l’accessibilité, l’expérience utilisateur et une installation rapide. CasaOS, ZimaOS et UmbrelOS Ces systèmes (ou surcouches, selon les cas) cherchent à transformer un serveur en « cloud personnel » facile à prendre en main. Les interfaces sont modernes, visuelles et l’installation d’applications ressemble à un App Store… On déploie des services en quelques clics, ce qui les rend attractifs pour démarrer vite. La limite est structurelle : ce ne sont pas, à la base, des OS orientés « stockage avancé ». La gestion RAID, la stratégie de protection des données et les scénarios de migration/extension sont sommaires (rien à voir comparé à TrueNAS et Unraid). Ils sont donc très adaptés à un premier serveur multimédia/domotique, mais moins pertinent si vous cherchez une plateforme de stockage « sérieuse » pour des données réellement critiques. HexOS HexOS est très attendu (toujours en Bêta), car l’ambition est séduisante : proposer la puissance d’une base type TrueNAS avec une interface beaucoup plus simple. C’est une piste intéressante pour ceux qui veulent une expérience plus « grand public » sans renoncer à une base technique solide. Point important : c’est un produit payant. Son intérêt dépendra de son niveau de maturité et de la qualité de l’intégration au quotidien. L’alternative : virtualisation avec Proxmox Techniquement, Proxmox VE n’est pas un OS de NAS : c’est un hyperviseur. Mais en 2026, c’est la base de nombreuses installations homelab. Le principe est simple : vous installez Proxmox sur le matériel (bare metal), puis vous déployez votre NAS (TrueNAS, OMV…) dans une machine virtuelle et vos autres services dans d’autres VM ou conteneurs. L’intérêt ici, c’est que vous séparez les rôles. Vous facilitez les sauvegardes complètes (snapshots, export) et vous rendez l’infrastructure plus résiliente. Si un service tombe, le reste continue de tourner et vous pouvez restaurer proprement. Cependant, c’est une approche plutôt réservée aux utilisateurs avancés. Elle demande une bonne maîtrise des notions de stockage (pass-through, contrôleurs, performances, sécurité des données). Que choisir en 2026 ? Le choix ne dépend plus uniquement des fonctionnalités (Docker est devenu un standard), mais de votre priorité? Vous voulez : Protéger vos données avant tout : TrueNAS Scale Recycler des disques variés et évoluer facilement : Unraid Une solution simple, légère, proche de Linux : OMV Une belle interface et démarrage rapide : CasaOS ou ZimaOS Un homelab complet et une infra modulaire : Proxmox Certains diront que le NAS DIY est à son apogée. De mon côté, je le vois plutôt comme une étape : les outils se simplifient, les standards se consolident et le niveau de finition continue de monter. Reste à choisir l’approche qui correspond à vos contraintes… et à votre tolérance à la complexité. Afficher l’article complet

-

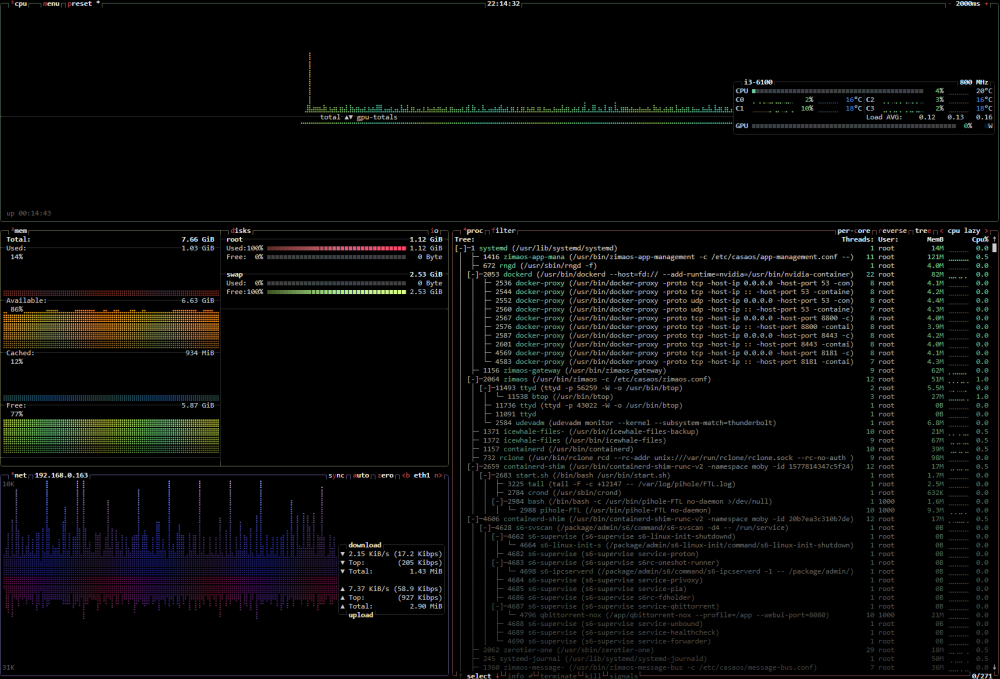

Up and Clear | Reborn upandclear.org Environ 5 minutes de lecture Après avoir mis de côté UNRAiD, dont je me suis lassé, j’ai passé le LincStation N1 sous TrueNAS. Cet OS ne m’apporte rien d’autre que la gestion simplifiée des RAIDs via une WebUI (parce que bon… mdadm… c’est chiant). Enfin je ne cherche pas à utiliser l’OS pour être précis, je ne peux donc pas dire qu’il est nul ou top. M’en tape. Les autres machines, tout aussi peu puissantes que le N1 sont sous Archlinux et Ubuntu. Arch parce que j’aime bien me demander chaque jour si une MàJ va plomber le serveur et comment je vais m’en dépatouiller (et c’est accessoirement mon desktop). Ubuntu, pour changer de Debian, parce que j’ai quand même besoin d’un truc stable dans ma vie de geek. N’utilisant quasi plus de VM/LXC depuis l’avènement de Docker, je n’ai plus de ProxMox. Du coup, je shunte Ubuntu au profit d’une distribution basée sur Debian : ZimaOS ! Jai passé hier l’ensemble de mes services « utiles » sur TrueNAS pour libérer cette machine pour ce test. Avertissement : c’est asiat’. Alors pour les complotistes américains peureux bas du front (rayez ou non les mentions inutiles), n’allez pas plus loin. Je n’ai absolument pas fait de RE pour savoir s’ils ont mis des backdoors. « Mais » CVE-2026-21891 (non encore relayée sur GitHub) / discussion Reddit et si j’ai pas sniffé le trafic, mon DNS ne fait rien ressortir d’extraordinaire. La machine ping même pas Baidu, contrairement à la majorité des objets IoT qui s’assurent d’être connectés à Internet en pingant le de Google chinoix (oui, eux aussi ont leur GAFAM BATX). J’ai découvert cet OS par hasard, quand je cherchais des infos sur des boards de serveurs. J’ai d’ailleurs commencé par découvrir CasaOS, dont j’étais pas fans. Ça faisait un peu Docker in Docker. Pour moi c’est plus à voir comme une alternative à YunoHost (très bon projet pour ceux qui sortent d’une grotte et ne connaissent pas). Même ressenti pour Cosmos d’ailleurs. ZimaOS est développé pour leurs NAS ZimaCube mais on peut l’installer partout. Ils font eux-mêmes la comparaison entre ZimaOS et CasaOS, en gros : C’est un UNRAiD like, avec une interface plus moderne (avis 100% subjectif), avec des clients à la Synology pour Windows, macOS, Linux (AUR), iOS et Android, avec une documentation bien faite sans tomber dans un Wikipedia comme on peut le voir chez certains concurrents, un GitHub et donc la possibilité d’ouvrir des issues (ce qui est bien plus pratique qu’un forum), Ça s’installe en 2-2 avec une clé USB (iso de 1.3Go) créée avec Balena et se gère uniquement via la WebUI. J’utilise la version gratuite. Et il faut activer le Mode Développeur notamment pour désactiver l’indexation du contenu avec leur « IA » (pour faciliter la recherche) et autoriser SSH. Première vraie configuration à faire, mon stockage. De mémoire j’ai que 2 disques dans ce PC mais la version gratuite permet d’en gérer 4 en RAID. Et la version payante coûte 29$ (« à vie »). Comme j’ai qu’un SSD en sus de celui de l’OS, je me contente de le formater et ça l’ajoute bien ensuite en stockage. Ce que je vois d’ailleurs avec le widget de la dashboard, qui passe à 718Go de stockage. Et donc, en standard, ZimaOS intègre un explorateur de fichiers, un outil de backup (depuis ou vers le NAS), un gestionnaire de VM et un PairDrop (je vois la machine sous Windows mais pas mon Arch, faudra que je trouve pourquoi). Depuis un client (Linux/iOS), on peut parcourir les fichiers du serveur et faire du backup. Notamment de photos depuis l’iPhone (arrière plan ou non). On peut ajouter des liens externes à la dashboard, ce qui est une très bonne idée et pourrait m’inciter à me passer de mon brave Heimdall qui m’accompagne depuis maintenant des années… Et nous terminons évidemment avec le fameux AppStore et ses 372 applications (Docker) « prêtes à installer » au moment de cet article. Rien de comparable avec UNRAiD, je vous l’accorde. Mais ici, ça s’installe en 1 clic. Et on peut ajouter des dépôts et doubler, au moins, le nombre d’applications du store. Tout comme il est possible d’installer une app via la WebUI si on elle n’est pas dans le Store et qu’on n’est vraiment pas à l’aise en console. On peut tout à fait utiliser Docker en console ou via Komodo, Arcane, Dockge, Portainer/what ever. Et ça marche « out of the box » dans ce cas, il n’y a rien à adapter pour l’OS. À noter que par défaut, les applications installées via l’AppStore sont dans /DATA, sur le disque système. root@ZimaOS:~ ➜ # tree /DATA/ /DATA/ ├── AppData │ └── pihole │ └── etc │ └── pihole │ ├── adlists.list │ ├── cli_pw │ ├── config_backups │ │ └── pihole.toml.1 │ ├── dhcp.leases │ ├── dnsmasq.conf │ ├── gravity.db │ ├── gravity_backups │ │ └── gravity.db.1 │ ├── gravity_old.db │ ├── hosts │ │ └── custom.list │ ├── listsCache │ │ ├── list.1.raw.githubusercontent.com.domains │ │ ├── list.1.raw.githubusercontent.com.domains.etag │ │ └── list.1.raw.githubusercontent.com.domains.sha1 │ ├── logrotate │ ├── migration_backup │ │ └── adlists.list │ ├── pihole-FTL.db │ ├── pihole-FTL.db-shm │ ├── pihole-FTL.db-wal │ ├── pihole.toml │ ├── tls.crt │ ├── tls.pem │ ├── tls_ca.crt │ └── versions ├── Backup ├── Documents ├── Downloads │ └── ISO ├── Gallery ├── Media │ ├── Movies │ ├── Music │ └── TV Shows └── lost+found Comme ça se voit au-dessus, j’ai installé Pi-Hole depuis l’AppStore pour tester. Faut juste cliquer pour installer. Pratique : en cas d’ajout de disques, on peut migrer les données facilement Même si ZimaOS est basé sur Debian, c’est propriétaire et on ne peut pas utiliser Apt pour y installer ce qu’on veut. C’est une sécurité également, histoire de ne pas mettre en vrac l’OS (ce qu’on est nombreux à avoir fait avec Proxmox hein… mentez pas !!). Ceci dit ils ont prévu le coup. Ceci dit, leur OS embarque déjà bon nombre d’utilitaires tels que ncdu, jq, rclone… Dans l’idéal, j’aimerais un dash qui permet de mieux intégrer quelques applications comme le font Heimdall, Homarr, Organizr etc. Aperçu du client iOS Avec le recul de cet article, je perçois ZimaOS comme un DSM de Synology, enfin plutôt un Xpenology vu qu’on peut l’installer où on veut, avec un peu de combo d’UNRAiD et cousins. Enfin tous ces OS se ressemblent mais ZimaOS serait un peu le « macOS » du groupe, à vouloir proposer une expérience très esthétique, complète (Docker natif ou magasin d’applications), pratique (outils intégrés, y compris pour périphériques) et répondant AMHA à la plupart des besoins. Bien que propriétaire, contrairement à CasaOS qui est open source mais n’est qu’une surcouche. Je pense le faire tourner quelques temps en parallèle de TrueNAS voir remplacer ce dernier. Et j’avais oublié, ça embarque aussi Btop++ pour afficher des stats temps réel. Afficher l’article complet

-

Linux PatchMon : surveillez les mises à jour des machines Linux - IT Connect

Ldfa a posté un sujet dans Mon Wallabag

IT-Connect Publié le 12 janvier 2026 Par Florian BURNEL it-connect.fr Environ 12 minutes de lecture PatchMon est une solution open source de Patch Monitoring pour les serveurs Linux, qu'ils soient sous Debian, Ubuntu, Alma Linux ou encore Red Hat Enterprise Linux (RHEL). L'objectif principal de PatchMon est le suivant : vous offrir une vue d'ensemble sur l'état des mises à jour sur vos machines Linux. Ainsi, vous pouvez identifier facilement les machines sur lesquelles des mises à jour de paquets sont en attente, avec une mise en évidence des mises à jour de sécurité. Les machines sous Linux, au même titre que celles sous Windows, reçoivent des mises à jour. D'une part, il y a les mises à jour du système et du noyau, et d'autre part, les mises à jour des paquets installés (du paquet de la simple bibliothèque à celui d'un service utilisé en production). Comment suivre la disponibilité des mises à jour ? Si l'on prend l'exemple de machines sous Debian, exécuter les commandes apt update et apt upgrade manuellement n'est pas une solution viable et efficace. C'est là qu'un outil comme PatchMon apporte une valeur ajoutée : son tableau de bord affiche l'état des mises à jour de l'ensemble de vos machines Linux. Son fonctionnement repose sur l'installation d'un agent sur les machines à monitorer. À la clé : Un inventaire de vos machines (avec la répartition par type d'OS) Un aperçu du niveau de mises à jour de vos machines (à jour, en attente de mise à jour, en attente d'un redémarrage) Une visibilité sur le type de mises à jour en attente (distinction entre mise à jour standard et correctif de sécurité) Une tendance globale dans le temps Des statistiques globales sur l'ensemble de votre SI L'état de la réception des données de la part des agents Au-delà d'offrir une vue par machine, PatchMon offre aussi une vue par paquet : pratique pour identifier les machines sur lesquelles est installé tel ou tel paquet. Il référence aussi la liste des dépôts (repos) configurés sur vos machines. Précision importante : la version actuelle de PatchMon ne permet pas de gérer la mise à jour des paquets. Nous sommes donc dans une approche de monitoring, sans qu'il soit possible d'appliquer les mises à jour en attente. Mais les choses vont évoluer à l'avenir : la feuille de route évoque des fonctionnalités croustillantes, dont celle-ci. PatchMon est un projet qui a énormément progressé en quelques mois. L'intégration avec Docker pour remonter les informations sur les conteneurs, les images, etc... est actuellement en bêta, tandis que d'autres intégrations sont en préparation (Proxmox VE, etc.). C'est un projet à suivre en 2026 ! GitHub - PatchMon Installation du serveur PatchMon L'installation de PatchMon sera réalisée sur un serveur où Docker a été installé au préalable. Nous utiliserons un fichier Docker Compose car la stack PatchMon repose sur plusieurs conteneurs : Base de données avec PostgreSQL, Cache objet avec Redis, Backend de PatchMon, Frontend de PatchMon Créer un dossier pour le projet Docker Comme à mon habitude, j'ai créé un dossier dédié à ce projet sur mon serveur afin d'isoler les données associées à PatchMon. Le dossier suivant a été créé : /opt/docker-compose/patchmon Par la suite, trois sous-dossiers seront créés dans ce dossier (vous pouvez les créer manuellement ou laisser Docker procéder) : /opt/docker-compose/patchmon | |___ agent_files |___ postgres_data |___ redis_data Note : un quatrième dossier nommé branding_assets peut être ajouté si vous souhaitez déposer des éléments spécifiques pour personnaliser l'apparence de l'interface. Par exemple : remplacer le logo PatchMon par celui de votre entreprise. Générer 3 mots de passe Avant de créer le fichier Docker Compose, je vous invite à générer trois mots de passe qu'il sera nécessaire d'insérer dans ce fichier. Ils seront utilisés pour personnaliser les mots de passe de PostgreSQL et Redis, et pour le secret JWT. Voici à titre d'information les trois valeurs utilisées pour ce tutoriel et obtenues via la même commande que vous pouvez lancer sur votre serveur. # Mot de passe de la base de données openssl rand -hex 64 eb2b687f514ddcd25226de40437a59a0f9fbac5ffe72fda2e5e6d11b31e2b9e99c4aeb6944f73c37f76ba175082821a69fb625d1b080dac7df66a7ff1ea967af # Mot de passe Redis openssl rand -hex 64 0ba2b3084b93fa7bfb49452c23bea7a50c2772a9c1e3e83437db283ea37874e59febd0e09d77e1579348d2fb10cf46e7a7de17656bc7312099622fada8f42f23 # Secret JWT openssl rand -hex 64 e0b7f1ad9bd73bd271b3d161fb013c6a90e5de48e8ed4b0cb80d9717f4cb1886470671f527565158c37a1c78db92614287844eb95135abaee50ac60a0539a2cb Créer le fichier Docker Compose Voici le fichier docker-compose.yml que vous devez créer à la racine de votre projet PatchMon. Vous devez le personnaliser de façon à insérer vos mots de passe. J'ai mis des couleurs distinctes sur les trois valeurs pour que vous puissiez vous y retrouver. Cette configuration s'appuie sur la version disponible sur le GitHub officiel du projet. name: patchmon services: database: image: postgres:17-alpine restart: unless-stopped environment: POSTGRES_DB: patchmon_db POSTGRES_USER: patchmon_user POSTGRES_PASSWORD: eb2b687f514ddcd25226de40437a59a0f9fbac5ffe72fda2e5e6d11b31e2b9e99c4aeb6944f73c37f76ba175082821a69fb625d1b080dac7df66a7ff1ea967af volumes: - ./postgres_data:/var/lib/postgresql/data networks: - patchmon-internal healthcheck: test: ["CMD-SHELL", "pg_isready -U patchmon_user -d patchmon_db"] interval: 3s timeout: 5s retries: 7 redis: image: redis:7-alpine restart: unless-stopped command: redis-server --requirepass 0ba2b3084b93fa7bfb49452c23bea7a50c2772a9c1e3e83437db283ea37874e59febd0e09d77e1579348d2fb10cf46e7a7de17656bc7312099622fada8f42f23 volumes: - ./redis_data:/data networks: - patchmon-internal healthcheck: test: ["CMD", "redis-cli", "--no-auth-warning", "-a", "0ba2b3084b93fa7bfb49452c23bea7a50c2772a9c1e3e83437db283ea37874e59febd0e09d77e1579348d2fb10cf46e7a7de17656bc7312099622fada8f42f23", "ping"] interval: 3s timeout: 5s retries: 7 backend: image: ghcr.io/patchmon/patchmon-backend:latest restart: unless-stopped # See PatchMon Docker README for additional environment variables and configuration instructions environment: LOG_LEVEL: info DATABASE_URL: postgresql://patchmon_user:eb2b687f514ddcd25226de40437a59a0f9fbac5ffe72fda2e5e6d11b31e2b9e99c4aeb6944f73c37f76ba175082821a69fb625d1b080dac7df66a7ff1ea967af@database:5432/patchmon_db JWT_SECRET: e0b7f1ad9bd73bd271b3d161fb013c6a90e5de48e8ed4b0cb80d9717f4cb1886470671f527565158c37a1c78db92614287844eb95135abaee50ac60a0539a2cb SERVER_PROTOCOL: http SERVER_HOST: 192.168.10.200 SERVER_PORT: 3000 CORS_ORIGIN: http://192.168.10.200:3000 # Database Connection Pool Configuration (Prisma) DB_CONNECTION_LIMIT: 30 DB_POOL_TIMEOUT: 20 DB_CONNECT_TIMEOUT: 10 DB_IDLE_TIMEOUT: 300 DB_MAX_LIFETIME: 1800 # Rate Limiting (times in milliseconds) RATE_LIMIT_WINDOW_MS: 900000 RATE_LIMIT_MAX: 5000 AUTH_RATE_LIMIT_WINDOW_MS: 600000 AUTH_RATE_LIMIT_MAX: 500 AGENT_RATE_LIMIT_WINDOW_MS: 60000 AGENT_RATE_LIMIT_MAX: 1000 # Redis Configuration REDIS_HOST: redis REDIS_PORT: 6379 REDIS_PASSWORD: 0ba2b3084b93fa7bfb49452c23bea7a50c2772a9c1e3e83437db283ea37874e59febd0e09d77e1579348d2fb10cf46e7a7de17656bc7312099622fada8f42f23 REDIS_DB: 0 volumes: - ./agent_files:/app/agents networks: - patchmon-internal depends_on: database: condition: service_healthy redis: condition: service_healthy frontend: image: ghcr.io/patchmon/patchmon-frontend:latest restart: unless-stopped ports: - "3000:3000" networks: - patchmon-internal depends_on: backend: condition: service_healthy volumes: postgres_data: redis_data: agent_files: networks: patchmon-internal: driver: bridge Dans ce fichier, vous pourrez constater que : Les conteneurs seront connectés sur le même réseau Docker intitulé patchmon-internal, L'application est exposée sur le port 3000 via le conteneur frontend, Des dépendances sont définies entre certains conteneurs via les instructions depends_on. Au-delà des mots de passe et secrets, vous devez ajuster plusieurs variables pour éviter d'avoir une erreur de sécurité lors de la première connexion : SERVER_PROTOCOL: http : http ou https, selon la méthode d'accès. SERVER_HOST: 192.168.10.200 : le nom public du serveur, mettez l'IP ou le nom. SERVER_PORT: 3000 : le port d'accès, doit être cohérent vis-à-vis du port exposé sur le frontend. CORS_ORIGIN: http://192.168.10.200:3000 : ajustez cette valeur pour qu'elle représente l'adresse publique sur laquelle sera joignable PatchMon. Autrement dit, n'indiquez pas localhost ou 127.0.0.1. Ici, je précise l'adresse IP de mon hôte Docker car les échanges seront uniquement sur le réseau local. Ici, nous effectuons un accès en HTTP à l'application PatchMon. Pour la production, il est bien entendu recommandé d'associer un reverse proxy pour publier l'application en HTTPS, avec un certificat TLS. Pour aller plus loin, il y a d'autres variables d'environnement disponibles : référez-vous à cette page de la documentation. Enregistrez et fermez le fichier. Initialiser le projet Docker Compose Désormais, vous pouvez initialiser le projet Docker. Les images seront téléchargées, le réseau créé, tout comme les différents conteneurs. Patientez un instant. docker compose up -d Si vous avez une erreur, consultez les journaux : docker compose logs Il est possible que le conteneur backend refuse de démarrer à cause d'une erreur de permissions sur le dossier agent_files. Vous pouvez corriger cette erreur via la commande suivante : sudo chown -R 1000:1000 /opt/docker-compose/patchmon/agent_files Première connexion à PatchMon Ouvrez votre navigateur web et tentez d'accéder à l'interface de PatchMon, en saisissant son adresse. Saisissez l'adresse associée au paramètre CORS_ORIGIN. Pour ma part, ce sera donc : http://192.168.10.200:3000. Vous devez commencer par créer un premier compte utilisateur correspondant à l'administrateur de la plateforme PatchMon. Voilà, bienvenue sur votre instance PatchMon ! Je vous encourage à prendre le temps de parcourir les paramètres, en cliquant sur le bouton "Settings" en bas à gauche. Il y a plusieurs sections, que ce soit pour gérer les comptes utilisateurs, les rôles, votre profil, ou encore les groupes d'hôtes. Par exemple, vous pouvez activer le MFA sur votre compte administrateur. Cliquez sur "URL Config" dans la liste pour vérifier que l'adresse du serveur est bien prise en charge. C'est important de le vérifier, même si ça doit déjà être correct grâce aux variables SERVER_* configurées précédemment. Cette page affiche l'adresse qui sera utilisée par les clients pour contacter le serveur PatchMon. Si c'est incorrect, vous allez rencontrer des problèmes par la suite... Une fois que vous avez terminé votre petit tour de l'interface PatchMon, passez à la suite : le déploiement d'un premier agent. Déployer un agent PatchMon sur Linux Pour ajouter manuellement un nouvel hôte à PatchMon, vous devez déployer un nouvel agent. À partir de la section "Hosts", cliquez sur le bouton "Add host" (ou directement sur le "+" dans le menu de gauche). Pour le moment, la liste des hôtes est vide. Donnez un nom à cette machine, en toute logique le nom du serveur cible. Il est aussi possible : d'ajouter l'hôte à un groupe d'hôtes, mais par défaut il n'y a pas de groupe. C'est modifiable par la suite. d'activer une intégration, soit pour le moment l'intégration avec Docker (d'autres sont en cours de développement). Cliquez sur le bouton "Create Host" pour valider. Une fenêtre va s'afficher à l'écran. Elle indique la commande à copier-coller pour automatiser l'installation de l'agent PatchMon et l'inscription auprès du serveur. Pour ma part, la commande à exécuter est la suivante : curl -s http://192.168.10.200:3000/api/v1/hosts/install -H "X-API-ID: patchmon_2a08e8a52f0ae9fb" -H "X-API-KEY: 5bbc4e017f9c4a0ca8e485d11fd911e85e4768a38f5e832be1826d68532714e1" | sh Si vous ne lancez pas la commande directement en tant que root, vous devez ajouter sudo juste devant sh dans la seconde partie de la commande. L'opération est effectuée en quelques secondes. Les informations dans la console permettent d'avoir un aperçu des actions effectuées. Vous devriez voir passer deux lignes indiquant que les identifiants sont valides et que la connexion au serveur a été effectuée avec succès. Quelques précisions : Les identifiants de connexion à l'API sont stockés dans le fichier /etc/patchmon/credentials.yml. Le fichier de configuration, comprenant notamment l'adresse vers le serveur, est le fichier suivant : /etc/patchmon/config.yml. Le fichier journal de l'agent PatchMon est le suivant : /etc/patchmon/logs/patchmon-agent.log Suite à l'installation, l'hôte apparait bien sur l'interface de PatchMon. Vous pouvez actualiser les données en cliquant sur le bouton en haut à droite. Sur cette machine, on voit bien qu'il y a un retard considérable au niveau des mises à jour ! Note : l'agent PatchMon est équipé d'une fonction de mise à jour automatique activée par défaut. PatchMon collecte des informations générales sur la machine, en particulier pour le réseau, le système et le stockage. Vous pouvez naviguer entre les différents onglets : Sur le même principe, vous pouvez ajouter d'autres hôtes. La vue globale offrira alors une vue synthétique sur les hôtes enregistrés. Les commandes pour gérer l'agent PatchMon Voici quelques commandes utiles pour administrer l'agent PatchMon sur un serveur. Tester la connexion : patchmon-agent ping --------------------------------- ✅ API credentials are valid ✅ Connectivity test successful Lancer une synchronisation depuis l'agent : patchmon-agent report Afficher l'état de l'agent : patchmon-agent diagnostics --------------------------------- ✅ API credentials are valid ✅ Connectivity test successful root@srv-haproxy:~# patchmon-agent diagnostics PatchMon Agent Diagnostics v1.3.7 System Information: OS: Debian GNU/Linux 12 (bookworm) Architecture: amd64 Kernel: 6.1.0-25-amd64 Hostname: srv-haproxy Machine ID: 7cf53fba-b483-4621-9d3a-461833b6c214 Agent Information: Version: 1.3.7 Config File: /etc/patchmon/config.yml Credentials File: /etc/patchmon/credentials.yml Log File: /etc/patchmon/logs/patchmon-agent.log Log Level: info Configuration Status: ✅ Config file exists ✅ Credentials file exists Network Connectivity & API Credentials: Server URL: http://192.168.10.200:3000 ✅ Server is reachable ✅ API is reachable and credentials are valid Last 10 log entries: time="2026-01-08T11:06:57" level=info msg="Reboot status check completed" installed_kernel=6.1.0-25-amd64 needs_reboot=false reason= running_kernel=6.1.0-25-amd64 time="2026-01-08T11:06:57" level=info msg="Collecting package information..." time="2026-01-08T11:07:01" level=info msg="Found packages" count=360 time="2026-01-08T11:07:01" level=info msg="Collecting repository information..." time="2026-01-08T11:07:01" level=info msg="Found repositories" count=6 time="2026-01-08T11:07:01" level=info msg="Sending report to PatchMon server..." time="2026-01-08T11:07:02" level=info msg="Report sent successfully" time="2026-01-08T11:07:02" level=info msg="Processed packages" count=360 time="2026-01-08T11:07:07" level=info msg="Checking for agent updates..." time="2026-01-08T11:07:07" level=info msg="Agent is up to date" version=1.3.7 Afficher l'état du service : systemctl status patchmon-agent Afficher les logs de l'agent PatchMon : journalctl -u patchmon-agent -f Redémarrer le service : systemctl restart patchmon-agent Le monitoring de Docker avec PatchMon Si vous installez l'agent PatchMon sur une machine équipée de Docker et que vous activez l'intégration Docker, vous pourrez alors suivre l'état de vos conteneurs depuis l'interface de PatchMon. Toujours dans l'esprit monitoring, l'interface affiche l'état des conteneurs, la liste des images, des réseaux et des volumes. Pour le cas des images, ce qui est cool, c'est que PatchMon indique s'il y a une mise à jour disponible ou non, ainsi que d'autres informations (nom, tag, source, etc.). J'ai constaté qu'au début les images remontent toutes en "Up to date" (à jour), mais que l'état réel apparaît un peu plus tard. Ci-dessous, un exemple. Au niveau de chaque hôte, vous pouvez activer ou désactiver des intégrations, que l'on peut considérer comme des modules, via l'onglet "Integrations". Le site de PatchMon laisse entendre que d'autres intégrations arriveront par la suite : WordPress, Apache, Ubiquiti, Proxmox, Azure ou encore Google (vous pouvez voter d'ailleurs). Conclusion Si vous gérez déjà vos mises à jour de façon automatisée (avec Ansible, par exemple), le fait d'utiliser PatchMon ajoute une couche de monitoring intéressante pour savoir quand il est nécessaire d'agir sur tel ou tel serveur. C'est vrai pour un Home Lab et pour une petite infrastructure où PatchMon peut se faire une place pour apporter une meilleure visibilité. La solution PatchMon est jeune, mais elle évolue vite, et j'ai le sentiment qu'elle va progresser dans la bonne direction. Une communauté d'une dizaine de personnes contribue déjà au développement de la solution et le projet semble bien reçu ! Maintenant, nous attendons avec impatience la gestion des mises à jour et, pourquoi pas, à terme, la prise en charge des machines sous Windows. FAQ PatchMon Qu'est-ce que PatchMon ? PatchMon est un outil open source de surveillance des correctifs (patch monitoring) pour les systèmes Linux. Il offre un tableau de bord centralisé permettant de visualiser l'état des mises à jour (paquets installés, mises à jour de sécurité manquantes, etc.) sur l'ensemble de vos serveurs, sans avoir à s'y connecter individuellement. Il supporte aussi la découverte des conteneurs Docker et des conteneurs LXC sur les hôtes Proxmox VE. Comment fonctionne la communication entre mes serveurs et PatchMon ? L'architecture de PatchMon repose sur un modèle "agent-serveur". Un agent codé en Go est installé sur chaque machine Linux à surveiller. Cet agent initie la connexion vers votre serveur PatchMon (il est donc question d'une communication sortante uniquement). Vous n'avez pas besoin d'ouvrir de ports entrants sur vos serveurs surveillés, ce qui est un bon point pour la sécurité. Comment déployer en masse l'agent PatchMon ? La façon la plus adaptée de déployer l'agent PatchMon en masse sur un ensemble de machines Linux me semble être l'utilisation d'un playbook Ansible. D'ailleurs, au sujet d'Ansible, sachez qu'il y a un plugin d'inventaire dynamique PatchMon pour Ansible (voir cette page). PatchMon peut-il découvrir les conteneurs LXC de Proxmox VE ? Oui, PatchMon dispose d'une fonction nommée "Proxmox Auto-Enrollment" pour découvrir et inscrire automatiquement les conteneurs LXC des hôtes Proxmox VE. Le script de découverte tourne directement sur l'hôte Proxmox VE. Cette fonctionnalité est décrite sur cette page de la documentation. Ingénieur système et réseau, cofondateur d'IT-Connect et Microsoft MVP "Cloud and Datacenter Management". Je souhaite partager mon expérience et mes découvertes au travers de mes articles. Généraliste avec une attirance particulière pour les solutions Microsoft et le scripting. Bonne lecture. Afficher l’article complet -

Proxmox Quelles sont les nouveautés de Proxmox VE 9.1 ? - IT Connect

Ldfa a posté un sujet dans Mon Wallabag

durée de lecture : 2 min L'hyperviseur open source Proxmox VE évolue avec la sortie d'une nouvelle version : Proxmox VE 9.1. Quelles sont les nouveautés introduites par cette mouture disponible depuis le 19 novembre 2025 ? Voici un récapitulatif. LXC depuis des images OCI, snapshots vTPM et virtualisation imbriquée La nouveauté la plus marquante est sans doute l’intégration de la prise en charge des images OCI (Open Container Initiative) pour la création de conteneurs LXC. C'est réellement une nouveauté importante pour Proxmox VE. Il est désormais possible d'importer ou de télécharger des images standardisées depuis des registres publics afin d’en faire des modèles LXC. Ce standard est notamment utilisé par le Docker Hub. Pour autant, cela ne signifie pas que Proxmox VE intègre Docker, car il n'utilise pas le moteur Docker. Il continue d'utiliser LXC avec la capacité d'utiliser des images prêtes à l'emploi. "Selon l'image, ces conteneurs sont provisionnés en tant que conteneurs système complets ou conteneurs d'application allégés. Les conteneurs d'application constituent une approche distincte et optimisée qui garantit un encombrement minimal et une meilleure utilisation des ressources pour les microservices.", précise Proxmox. Côté machines virtuelles, Proxmox VE 9.1 introduit la prise en charge du stockage de la puce vTPM dans le format qcow2. Cette amélioration permet de créer des snapshots complets de VM équipées d’un vTPM, y compris sur des stockages tels que NFS ou CIFS. Concrètement, ce sera apprécié par ceux qui exécutent des machines virtuelles Windows sur Proxmox VE. Autre évolution : un contrôle plus fin de la virtualisation imbriquée. Grâce à un nouveau flag vCPU, les administrateurs peuvent activer précisément les extensions nécessaires aux hyperviseurs imbriqués ou aux systèmes exploitant la Virtualization-based Security (VBS). "Cette option flexible offre aux administrateurs informatiques davantage de contrôle et constitue une alternative optimisée à la simple exposition du type de processeur hôte complet à l'invité.", précise Proxmox. Une observabilité SDN enrichie pour les infrastructures complexes Le communiqué de Proxmox précise aussi que Proxmox VE 9.1 améliore la stack SDN, en proposant une interface beaucoup plus détaillée pour la supervision réseau. Le tableau de bord de Proxmox VE permettra d'identifier plus facilement l'ensemble des invités (VM, conteneurs) connectés à un pont ou à un vNet. "L'interface graphique mise à jour offre une visibilité sur les composants clés du réseau, tels que les VRF IP et les VRF MAC.", précise le document. Proxmox VE 9.1 est basé sur Debian 13.2 Alors que Proxmox VE 9 est basé sur Debian 13, cette nouvelle version est basée sur Debian 13.2. Comme l'explique la documentation de Proxmox, d'autres paquets importants ont été mis à jour, tout comme le noyau Linux qui passe en version 6.17.2-1. QEMU 10.1.2 LXC 6.0.5 ZFS 2.3.4 Ceph Squid 19.2.3 Qu'en pensez-vous ? Envie d'apprendre à utiliser Proxmox VE ? Commencez par lire mon guide pour bien débuter : Débuter avec Proxmox VE : installation et premiers pas Mise à niveau de Proxmox VE 8 vers 9 Source Afficher l’article complet -

Serveur dédié MAJ serveurs dédiés vers Proxmox 9.0

Ldfa a posté un sujet dans Nouveautés du Site Maxthon-fr.com

J'ai fait la mise à jour des serveurs dédiés vers Proxmox 9.0 la semaine dernière, les changements sont disponibles ici : https://pve.proxmox.com/wiki/Roadmap#Proxmox_VE_9.0 Un de ces serveurs dédiés héberge, entre autre, le site de Support Francophone de Maxthon. J'ai eu un souci lors de la MAJ et le serveur dédié a refusé de redémarrer. J'ai été obligé de réinstaller entièrement le serveur dédié et restaurer les sauvegardes des serveurs virtuels Tout semble fonctionner depuis... -

Proxmox Proxmox VE - La gestion des snapshots sur les VM - IT-Connect

Ldfa a posté un sujet dans Mon Wallabag

durée de lecture : 7 min Parmi les fonctionnalités offertes par Proxmox VE pour gérer les machines virtuelles et les conteneurs, il y a les snapshots et les sauvegardes. Bien que ces deux fonctionnalités soient associées à la protection des données, elles servent des objectifs distincts et fonctionnent différemment. Cet article fait un focus sur les snapshots avec les machines virtuelles Proxmox, mais il me semble important d'y associer un rappel sur les différences entre les snapshots et les sauvegardes (backup). Cliquez ici pour regarder la vidéo sur YouTube Il y a parfois une certaine confusion entre les snapshots et les backups, et pourtant, les intérêts de ces deux fonctionnalités sont différents. Snapshots (Instantanés) Un snapshot dans Proxmox VE est une capture de l'état d'une VM ou d'un conteneur à un moment précis. Son principal objectif est de créer un point de restauration rapide afin de pouvoir revenir en arrière (ou naviguer entre plusieurs états). Lorsque vous prenez un snapshot, Proxmox VE enregistre la configuration de la VM à ce moment-là. Ensuite, toutes les modifications ultérieures de la VM sont écrites dans un nouveau fichier, tandis que les données d'origine restent inchangées, permettant ainsi de revenir rapidement à l'état capturé. En général, ces données sont stockées dans le même répertoire que les données de la machine virtuelle en elle-même. L'objectif principal est de pouvoir revenir rapidement à un état antérieur en cas de problème (par exemple, après une mise à jour logicielle ratée, une modification de configuration risquée ou pour des tests). Le snapshot a vocation à être temporaire. Backups (Sauvegardes) Une sauvegarde est une copie complète et autonome des données et de la configuration d'une VM ou d'un conteneur à un moment donné. Pour réaliser ses sauvegardes, Proxmox VE s'appuie l'outil de sauvegarde intégré : vzdump, à ne pas confondre avec la solution Proxmox Backup Server. Cet outil crée une archive complète des données de la ressource (machine virtuelle ou snapshot), y compris les fichiers de configuration. La sauvegarde, quant à elle, est de préférence stockée sur un espace de stockage externe (NAS ou autre). L'objectif principal est d'assurer la récupération après sinistre (perte de données, erreur système critique, etc.) ou l'archivage à long terme. Une sauvegarde, contrairement à un snapshot, est associé à une stratégie de rétention. Pour commencer, nous verrons comment créer, modifier, restaurer et supprimer un snapshot à partir de l'interface web (GUI) de Proxmox VE. Ce sera l'occasion de voir la mécanique de fonctionnement des snapshots en prenant un exemple. Avant de commencer, voici une précision associée au format du disque et la compatibilité avec les snapshots : Le format qcow2 (QEMU image format) prend en charge nativement les snapshots de l'image disque. Le format raw (image disque brute) ne prend pas en charge les snapshots par lui-même, donc il nécessite que la couche de stockage gère cette fonctionnalité. Autrement dit, dans certains cas, il se peut que les snapshots ne soient pas possibles ! Vous pouvez consulter le tableau sur cette page, il offre une bonne vue d'ensemble. Nous allons voir comment créer un snapshot d'une VM Proxmox. Actuellement, nous avons l'état suivant : une machine Debian 12 sur laquelle Apache2 n'est pas installé. Avant de procéder à l'installation, et pour avoir la possibilité de revenir en arrière, nous allons faire un snapshot. Voici les étapes à suivre : 1. Connectez-vous à votre interface web Proxmox VE. Dans l'arborescence des ressources à gauche, sélectionnez le nœud sur lequel la VM est hébergée. 2. Sélectionnez la VM pour laquelle vous souhaitez créer un snapshot, ici c'est la VM avec l'ID 100. 3. Dans le menu dédié à la VM, cliquez sur "Snapshots" puis sur le bouton "Take Snapshot". Une boîte de dialogue s'ouvrira. Vous devez alors saisir un nom, par exemple Snap1-20250723-Avant-Apache et une description. Sachez que vous pouvez créer plusieurs snapshots pour une même VM. Lors de la création d'un instantané sur une machine virtuelle, il y a une option nommée "Include RAM". Cochez cette option si vous souhaitez que le snapshot inclue l'état de la mémoire vive de la VM. Cela permet de restaurer la VM exactement dans l'état où elle se trouvait au moment du snapshot, sans nécessiter un démarrage complet. Cliquez sur "Take Snapshot" pour confirmer. La création du snapshot est un succès, comme le prouve le message TASK OK dans la sortie. Désormais, l'état actuel (NOW) est positionné sous notre snapshot, puisque ce dernier correspond à un état antérieur. La date et l'heure à laquelle le snapshot a été créé est clairement spécifiée, ce qui est une information essentielle. Vous pouvez éditer un snapshot à tout moment, ce sera l'occasion de modifier sa description. Toujours sur ce même machine Debian 12, j'ai pu procéder à l'installation d'Apache2. Mais, finalement, j'aimerais revenir en arrière. Je pourrais prendre le temps de supprimer le paquet et nettoyer le système. Néanmoins, nous allons simplement restaurer le snapshot pour revenir à l'état antérieur. Suivez ces étapes : 1 - Toujours dans la gestion de la VM, cliquez sur "Snapshots" 2 - Sélectionnez le snapshot à restaurer. 3 - Cliquez sur le bouton d'action nommé "Rollback". 4 - Cliquez sur "Yes" pour valider. Attention, les modifications effectuées après l'état capturé dans l'instantané seront perdues. Patientez le temps de l'opération. À partir de là, le snapshot a été restauré, mais il est toujours présent. Si vous n'en avez plus besoin, il conviendra de le supprimer. J'en profite pour évoquer la possibilité de créer plusieurs snapshots. Vous pouvez ensuite naviguer entre les différents états. Ce qui est important, c'est le positionnement du pointeur "NOW". Ici, nous pouvons voir que l'état actuel est basé sur le snapshot Snap1, et non sur le Snap2. Avec ce second exemple, l'état actuel est basé sur le Snap2. Nous n'avons plus besoin de notre snapshot, alors il est temps de le supprimer. En effet, le snapshot peut avoir un impact sur les performances et aussi augmenter la consommation sur l'espace de stockage. N'oublions pas qu'il a vocation à être temporaire. Pour supprimer un snapshot, procédez toujours depuis la section "Snapshots" de la ressource. Vous devez simplement sélectionner le snapshot à supprimer et cliquez sur le bouton "Remove". Confirmez l'opération. Dans la suite de ce tutoriel, nous allons basculer en ligne de commande pour effectuer la gestion des snapshots sur une machine virtuelle. Avant de commencer, vous devez accéder à ce terminal, soit via l'interface web de Proxmox VE ou en connexion SSH directe. 1 - Cliquez sur votre nœud PVE sur la gauche. 2 - Sélectionnez "Shell" dans le menu et connectez-vous avec votre compte. 3 - Vous pouvez lister vos machines virtuelles avec la commande qm list. Vous devez utiliser la commande qm snapshot pour créer un snapshot. Celle-ci attend plusieurs informations comme l'ID de la VM et le nom du snapshot. La syntaxe à adopter est la suivante : qm snapshot <VMID> <NOM_DU_SNAPSHOT> [OPTIONS] Donc, pour créer un snapshot sur la VM avec l'ID 100, nommer ce snapshot Snap-avec-Shell et lui ajouter une description, tout en capturant l'état de la RAM, il conviendra d'exécuter cette commande : qm snapshot 100 Snap-avec-Shell --description "Snapshot créé depuis le Shell Proxmox" --vmstate true Vous pouvez ensuite lister les snapshots de cette VM : qm listsnapshot 100 Bien entendu, sur l'interface web de Proxmox, cet instantané est visible : Pour restaurer le snapshot que nous venons de créer, nous devons utiliser la commande qm rollback de cette façon : qm rollback <VMID> <NOM_DU_SNAPSHOT> Dans notre cas, la commande serait donc : qm rollback 100 Snap-avec-Shell Enfin, si nous n'avons plus besoin de ce snapshot, nous pouvons le supprimer avec une autre commande prévue à cet effet : qm delsnapshot. Elle s'utilise sur le même principe que la commande pour le rollback : qm delsnapshot <VMID> <NOM_DU_SNAPSHOT> Dans le cas présent, nous devons exécuter cette commande : qm delsnapshot 100 Snap-avec-Shell Logical volume "vm-100-state-Snap-avec-Shell" successfully removed. Logical volume "snap_vm-100-disk-0_Snap-avec-Shell" successfully removed. En suivant ce tutoriel, vous êtes en mesure de créer, restaurer et supprimer les snapshots sur les machines virtuelles (et les conteneurs) hébergés sur Proxmox VE. Vous pouvez procéder via l'interface web ou la ligne de commande, selon vos besoins. La ligne de commande est plus intéressante lorsqu'il y a des tâches à automatiser. Afficher l’article complet -

Serveur dédié MAJ serveurs dédiés vers Proxmox 8.3

Ldfa a posté un sujet dans Nouveautés du Site Maxthon-fr.com

Je viens de mettre à jour les serveurs dédiés vers Proxmox 8.3, les changements sont disponibles ici : https://pve.proxmox.com/wiki/Roadmap#Proxmox_VE_8.3 Un de ces serveurs dédiés héberge, entre autre, le site de Support Francophone de Maxthon. Un redémarrage du serveur dédié sera réalisé dans la soirée.